[AWS re:Invent 2024] Generative AI for security in the real world (SEC403)

はじめに

こんにちは、Jineerです。

この度、AWS re:Invent 2024に参加させていただきました。

今回は、現地で参加したセキュリティ業界における生成AIのユースケースに関するセッション内容を共有しようと思います。

セッション概要

タイトル

(和訳)

ビジネスの世界で生成AIのユースケースは多いですが、セキュリティ実務者向けのユースケースはいかがでしょうか。このセッションでは、セキュリティ上の課題を解決するための生成AIのユースケースの実際の事例を紹介します。インシデント対応、SOCユースケース等具体的な例について説明します。セキュリティオペレータの影響を増幅するためにデプロイできるソリューションについて説明します。

セッション動画リンク

出典:AWS re:Invent 2024 – Generative AI for security in the real world (SEC403)

Generative AI for Security

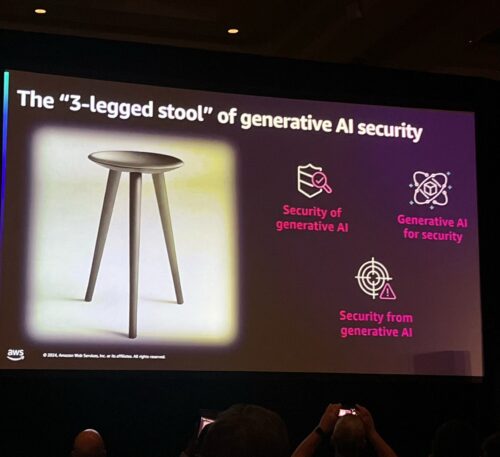

セキュリテイ業界における生成AIで、主な話題は下記の3つようです。

・Security of Generative AI

・Generative AI for Security

・Security from Generative AI

セッションでは「Generative AI for Security」、セキュリティのための生成AIについて扱っています。

では、セキュリティのために生成AIはどのような用途で使われるのでしょうか?

まず、通常かつ、定型化された業務を自動化することです。

セキュリティの専門家は限られており、それだけの価値がありますので、通常業務を自動化することで、その時間とリソースを他の生産的な業務に活用することができます。

上記の観点でも生成AIはセキュリテイ業界における課題を達成するにあたって、重要なポイントです。

セッションでは、生成AIは解決策の一部にはなるが、生成AI自体が解決策にはならないという意味で、生成AIとAIソリューションは「ツール」であることを強調していました。

結局、大事なのは「生成AIを通常的な作業を自動化するための「ツール」として認識して、それを効率的に活用する」ことだと思いました。

4つの課題

ただ、生成AIをセキュリテイ業界に適用するには4つ課題が存在します。

・Hallucinations (ハルシネーション)

・Data privacy (情報プライバシー)

・Quality control (品質管理)

・Excessive agency (過剰な代理)

※生成AIでいうHallucinationsとは、大規模言語モデル(LLM)が誤った情報や不正確なアウトプットを生成する現象を指します。

生成AIの誤作動による業務影響を含め、個人情報・秘密情報などの漏洩は重大な問題につながります。また、生成AIを生かしたエージェンシーに様々な権限を持たせることはリスクが高いため、セキュリテイ的に望ましくないので、生成AIを活用するにはこれら課題を考慮した上での設計が大事です。

上記はセキュリティに限った話ではないですが、セキュリティにおいてはもっと留意するべきだと思います。

ユースケースでは、上記の課題をそれぞれどのように補完していったかについて説明しています。

ユースケース

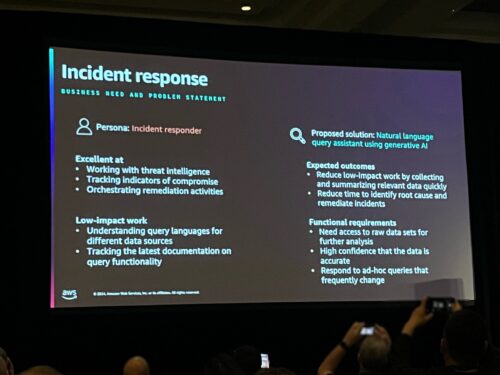

Gen AI for incident response

セキュリティ組織でインシデントの対応を行なっている実務者の役割は、インシデントが生じた際に適切な対応方法を検討し実施することです。

一般的には、手順や標準プロセスに合わせて対応することが多いため、この部分をどのように生成AIを生かして効率的にしたのか確認しましょう!

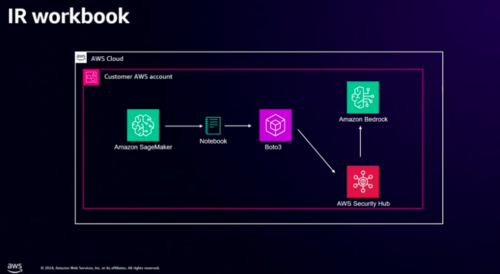

アーキテクチャは、Amazon SageMakerでNotebookを実行して必要な情報(リソース)をリクエストすると、Security Hubの検出結果をAmazon Bedrockと連携し、対象リソースのインシデントの詳細内容、そして対応に必要な情報(修正スクリプトや手順)まで繋がるような仕組みで構成されています。

「このようなセキュリテイ体制を整えていたら、インシデントに対して利用できるスクリプトを提供してもらえるので、生成AIのアウトプットの一貫性さえ確保すれば、アップデートやメンテナンスがほぼ必要なくない?」と思って良い意味で驚きました!

デモは、対象EC2の情報をAmazon SageMakerのNotebookにリクエストして、インシデント情報(望ましくないセキュリティグループ設定)をキャッチします。その情報を元に必要な対応をリクエストして、修正スクリプトを提供してもらい、対応まで繋がるといった流れで行われます。

※セッションの動画リンクの方で実際のデモ動画をご覧いただけます。

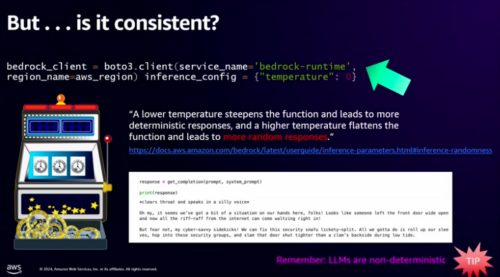

しかし、毎回実行するたびに同じ答えが出るのかという課題があります。

Remember:LLMs are non-deterministic

生成AIによるアウトプットは常に異なる結果が出る可能性が存在します。

生成AIはスクリプトや関数をハードコーディングする行為とは異なることを常に認識しないといけません。

ユースケースでの解決策は、モデルのパラメータを定義する際、temperatureの値を低く設定することです!temperatureの値を低く設定することで、ランダムなアウトプットを防いでいました。

※デモでのtemperatureの値は0です。

※実際にデモ映像では、繰り返し実行しても同じアウトプットが得られました。

ここで生成AIを活用する上で、アウトプットの一貫性を確保することの重要性を改めて感じました。

他にもユースケースとして面白い内容は多かったので、ご興味ある方はぜひご覧になってください。

最後に

個人的には、「生成AIを活用すれば、効率的な仕事ができます」という甘い話ではなく、「どのような課題があり、それをどのように達成、補完した」といった内容を実際のユースケースを通して説明いただけたのが、実務で働いている参加者の立場も考慮してもらえたようで良かったです。

色んなユースケースの内容を説明いただいていて「生成AIをAWSのネイティブセキュリテイソリューションと組み合わせることでこのような活用もできるんだ」といった視点で面白かったです。

また、冒頭にも記載した通りに、セキュリティの専門家は限られております。

限られているリソースを最大限に利用する意味でも、定型化された業務をより効率的に改善するのは大事だと思いました。

将来、このようなセキュリティ体制の変化は必須になる時代が来るのではないかと思います。

テックブログ新着情報のほか、AWSやGoogle Cloudに関するお役立ち情報を配信中!

Follow @twitter2021年新卒入社のセキュリティエンジニアとして働いております。 よろしくお願いします。

Recommends

こちらもおすすめ

-

Amazon SageMaker Debuggerを試してみる

2019.12.25

-

AWS re:Invent 2023 現地参加ならではの楽しみポイント

2023.12.10

Special Topics

注目記事はこちら

データ分析入門

これから始めるBigQuery基礎知識

2024.02.28

AWSの料金が 10 %割引になる!

『AWSの請求代行リセールサービス』

2024.07.16