TROCCO で始める ETL 入門 Google スプレッドシートのデータを BigQuery に転送する

2025.10.15

概要

データ分析を始めたいけれど、「ETL」という言葉を聞いて難しそうだと感じていませんか?

ETL とは、Extract(抽出)、Transform(変換)、Load(読み込み)の頭文字を取った言葉で、データ分析の前段階で必要不可欠なプロセスです。

- Extract(抽出) : 様々な場所にあるデータを取得する

- Transform(変換) : データを分析しやすい形に整える

- Load(読み込み) : 分析用のデータベースに保存する

従来、この ETL 作業には専門的なプログラミング知識が必要でしたが、TROCCO(トロッコ)を使えば、プログラミング不要で誰でも簡単にデータ連携ができるようになります。

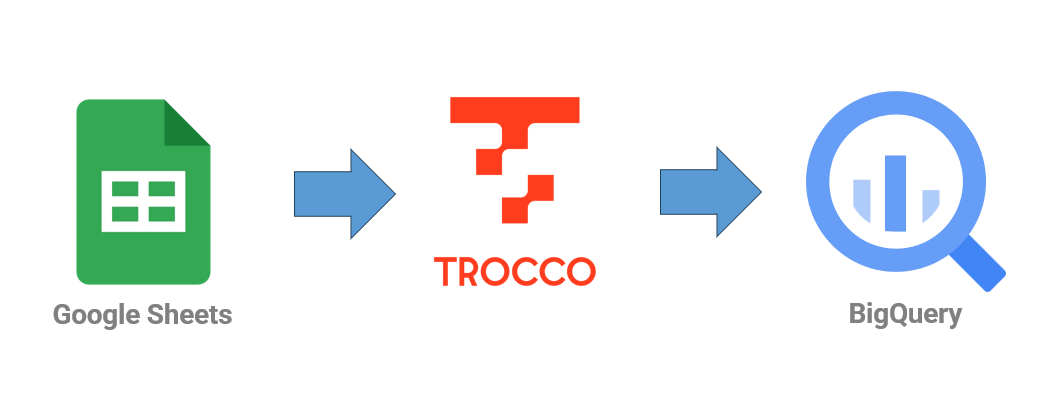

今回は TROCCO を用いて、多くの方が日常的に使っている Google スプレッドシートのデータを、Google の強力なデータ分析基盤 BigQuery に転送する方法を、実際の画面を見ながら解説します。

TROCCO とは?

TROCCO は、株式会社primeNumber が提供するクラウド ETL サービスです。

最大の特徴は、完全日本語対応で直感的な GUI 操作により、エンジニアでなくても簡単にデータ連携ができることです。

TROCCO(トロッコ) データ連携を自動にするクラウドETL

主な特徴

- 完全日本語対応

- インターフェースからサポートまで、すべて日本語

- 日本企業特有の SaaS や様々なツールにも幅広く対応

- プログラミング不要の GUI 操作

- 設定は画面の指示に従うだけ

- コードを書く必要は一切なし

- 非エンジニアでも安心して使える

- 以下のような職種の方でも簡単に利用できます

- マーケティング担当者

- 営業企画担当者

- 経営企画担当者

- データアナリスト

- 以下のような職種の方でも簡単に利用できます

- 豊富なコネクタ(100 種類以上)

- TROCCO の大きな強みの一つが、100 種類を超える豊富なデータソースに対応していることです

- 詳細は対応コネクタ一覧をご確認ください

料金プラン

今回は Free プランで設定を行いますが、処理時間や必要なコネクタが増えた場合はプランの変更をご検討ください。

| プラン | 月額料金 | 処理時間/月 | おすすめ用途 |

|---|---|---|---|

| Free | ¥0 | 2 時間 | お試し・学習用 |

| Starter | ¥75,000 | 30 時間 | 小規模チーム |

| Essential | ¥150,000 | 250 時間 | 中規模企業 |

| Advanced | ¥300,000 | 600 時間 | 大規模企業 |

Google スプレッドシートから BigQuery へのデータ転送手順

今回実現したいのは、Google スプレッドシートから BigQuery へのデータ転送です。

作業の流れ

作業は以下の流れで進めます。

- 事前準備

- 転送するデータの作成

- TROCCO アカウントの作成

- Google Cloud サービスアカウントの作成

- TROCCO 設定

- 接続情報の作成

- 転送設定の作成

- 転送ジョブの実行

- 動作確認

- BigQuery でデータを確認

事前準備

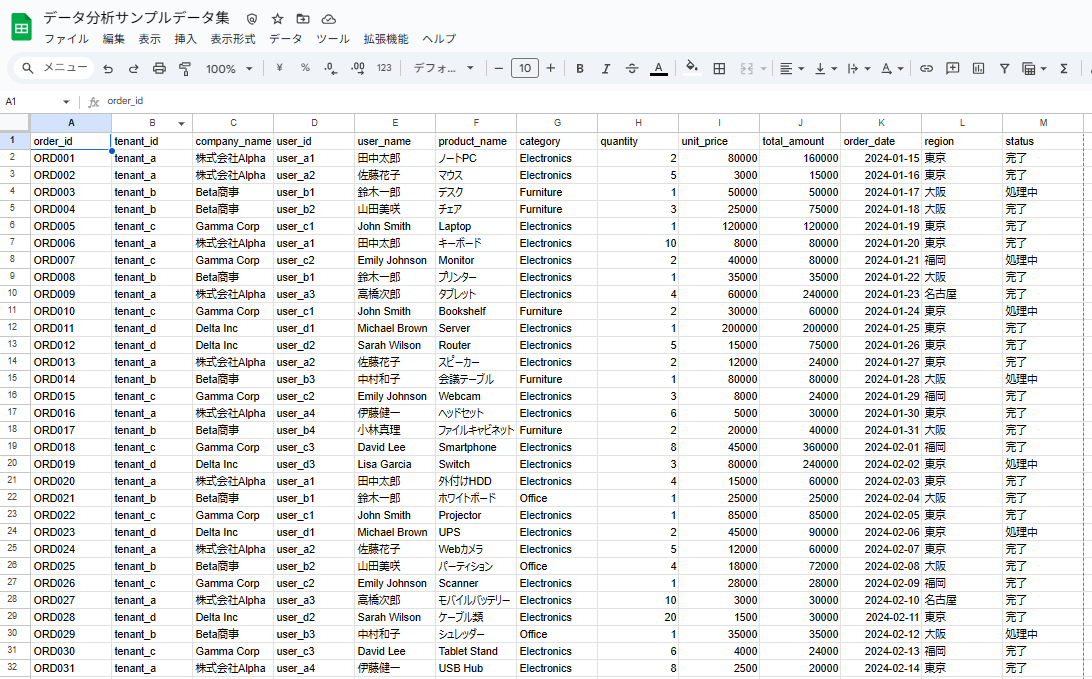

1. 転送するデータの作成

今回は生成 AI で作成したサンプルデータを使用します。

データの内容は以下の通りです。

order_id,tenant_id,company_name,user_id,user_name,product_name,category,quantity,unit_price,total_amount,order_date,region,status ORD001,tenant_a,株式会社Alpha,user_a1,田中太郎,ノートPC,Electronics,2,80000,160000,2024-01-15,東京,完了 ORD002,tenant_a,株式会社Alpha,user_a2,佐藤花子,マウス,Electronics,5,3000,15000,2024-01-16,東京,完了 ORD003,tenant_b,Beta商事,user_b1,鈴木一郎,デスク,Furniture,1,50000,50000,2024-01-17,大阪,処理中 ORD004,tenant_b,Beta商事,user_b2,山田美咲,チェア,Furniture,3,25000,75000,2024-01-18,大阪,完了 ORD005,tenant_c,Gamma Corp,user_c1,John Smith,Laptop,Electronics,1,120000,120000,2024-01-19,東京,完了

2. TROCCO アカウントの作成

TROCCO 公式サイトを開き、右上の「無料で始める」を選択します。

アカウント発行で必要な情報を入力します。

アカウント作成とログインが完了すると、トップ画面が表示されます。

※Free プランを継続利用しているため、画面表示が異なる場合があります

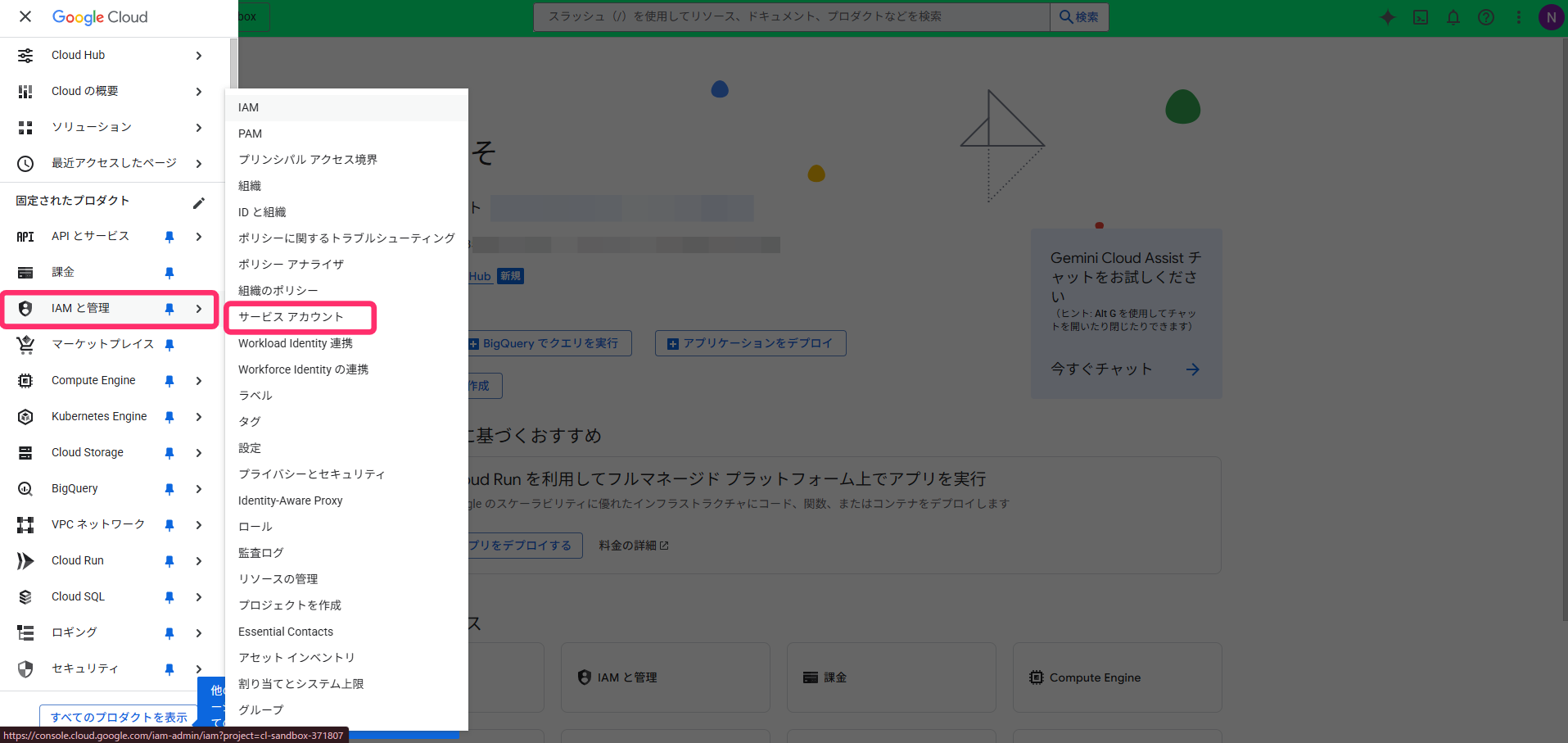

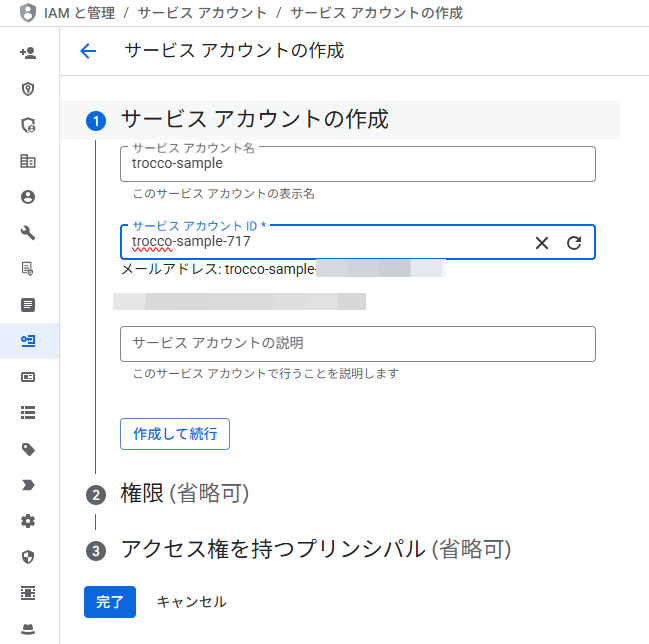

3. Google Cloud サービスアカウントの作成

TROCCO から BigQuery にアクセスするため、Google Cloud でサービスアカウントを作成します。

Google Cloud コンソールで「サービスアカウント」を選択します。

「サービスアカウントを作成」を選択します。

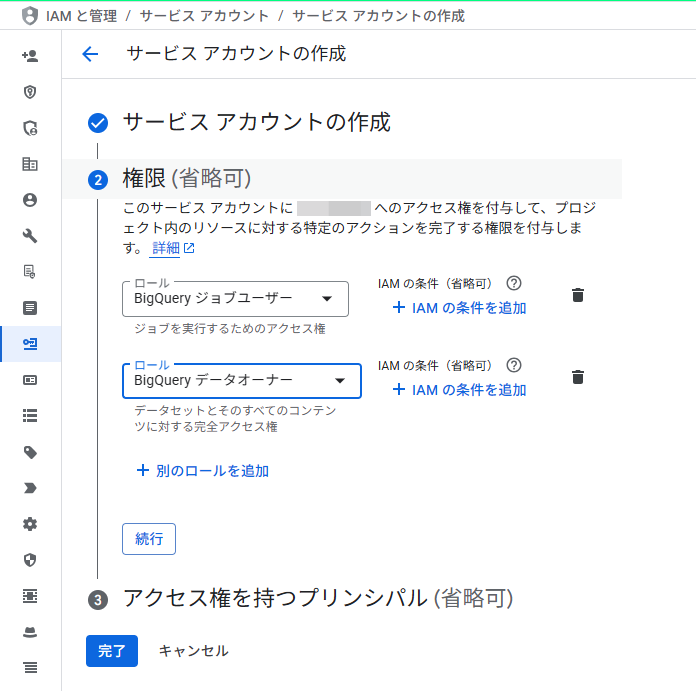

必要な情報を入力し、今回の権限設定では以下の 2 つを設定します。

- BigQuery ジョブユーザー

- BigQuery データオーナー

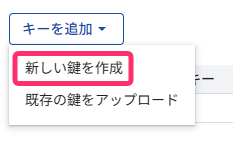

サービスアカウントの作成が完了したら、TROCCO で接続するための鍵を作成します。

「キーを追加」→「新しい鍵を作成」を選択します。

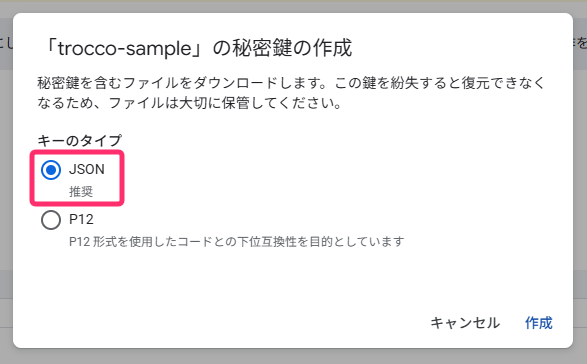

TROCCO は JSON のみ対応しているため、デフォルトの JSON を選択します。

TROCCO 設定

ここからは TROCCO 上の設定を行います。

1. 接続情報の作成

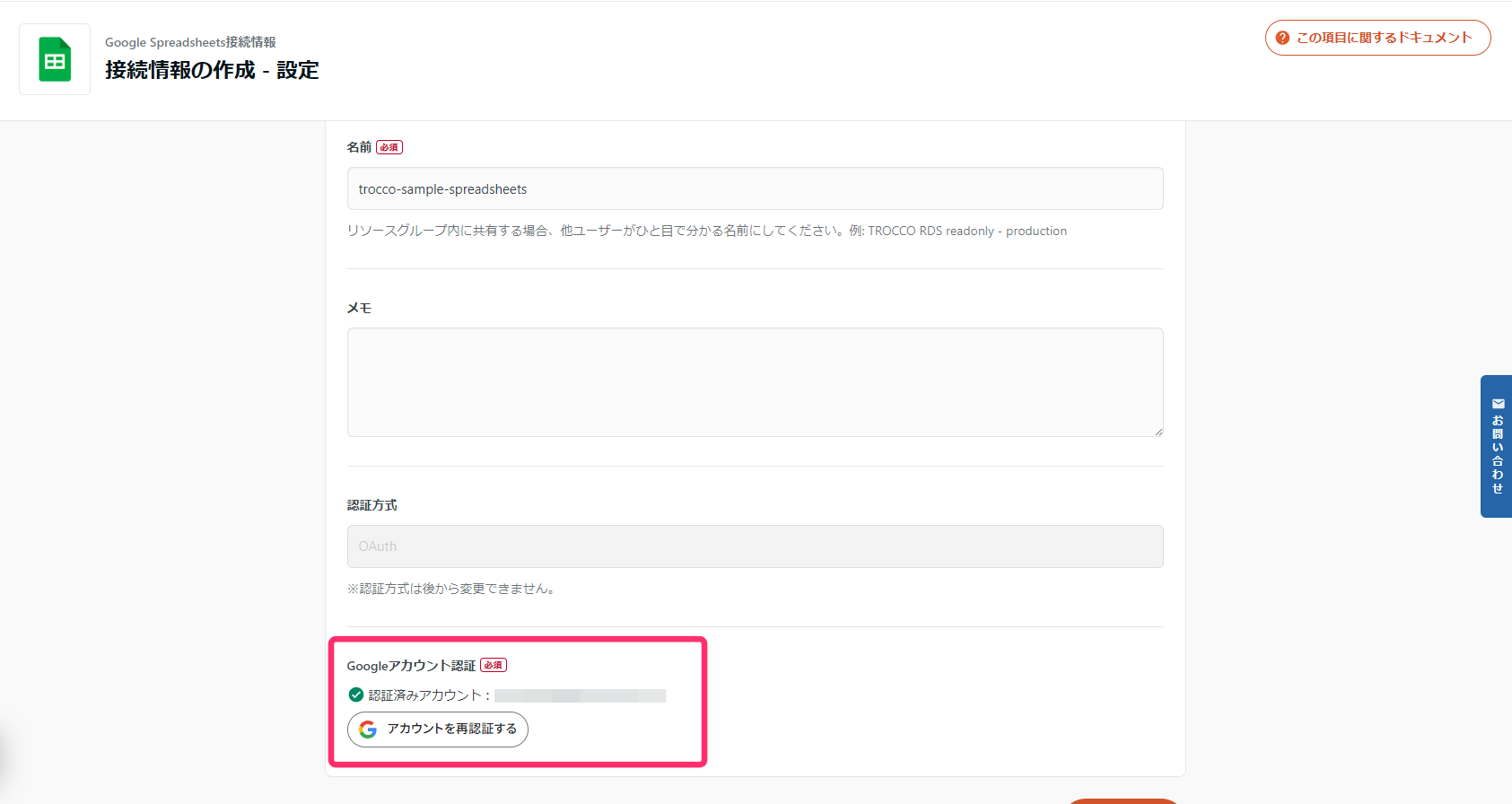

まずは、Google スプレッドシート接続情報を設定します。

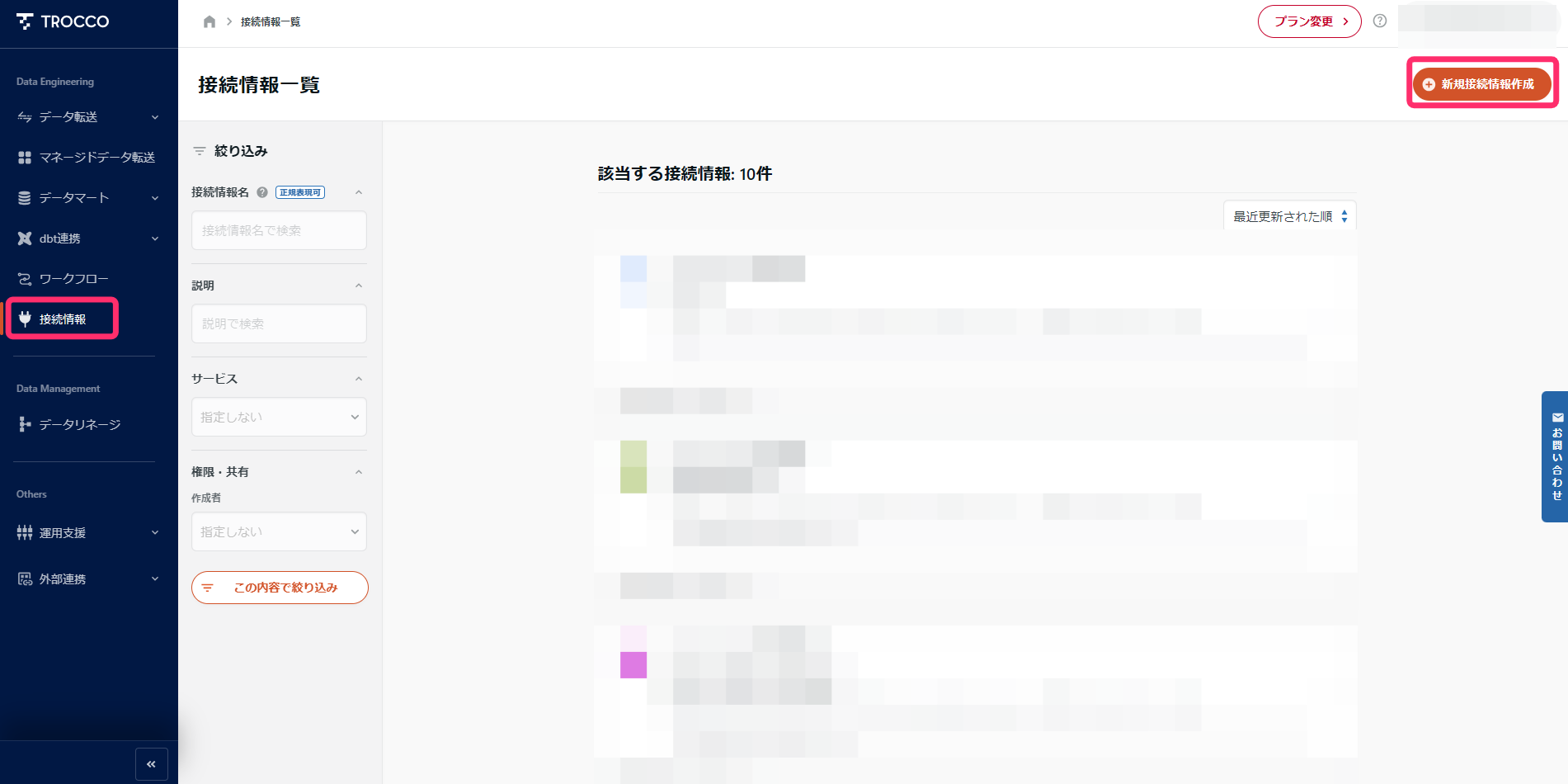

TROCCO の管理画面で「接続情報」を選択します。

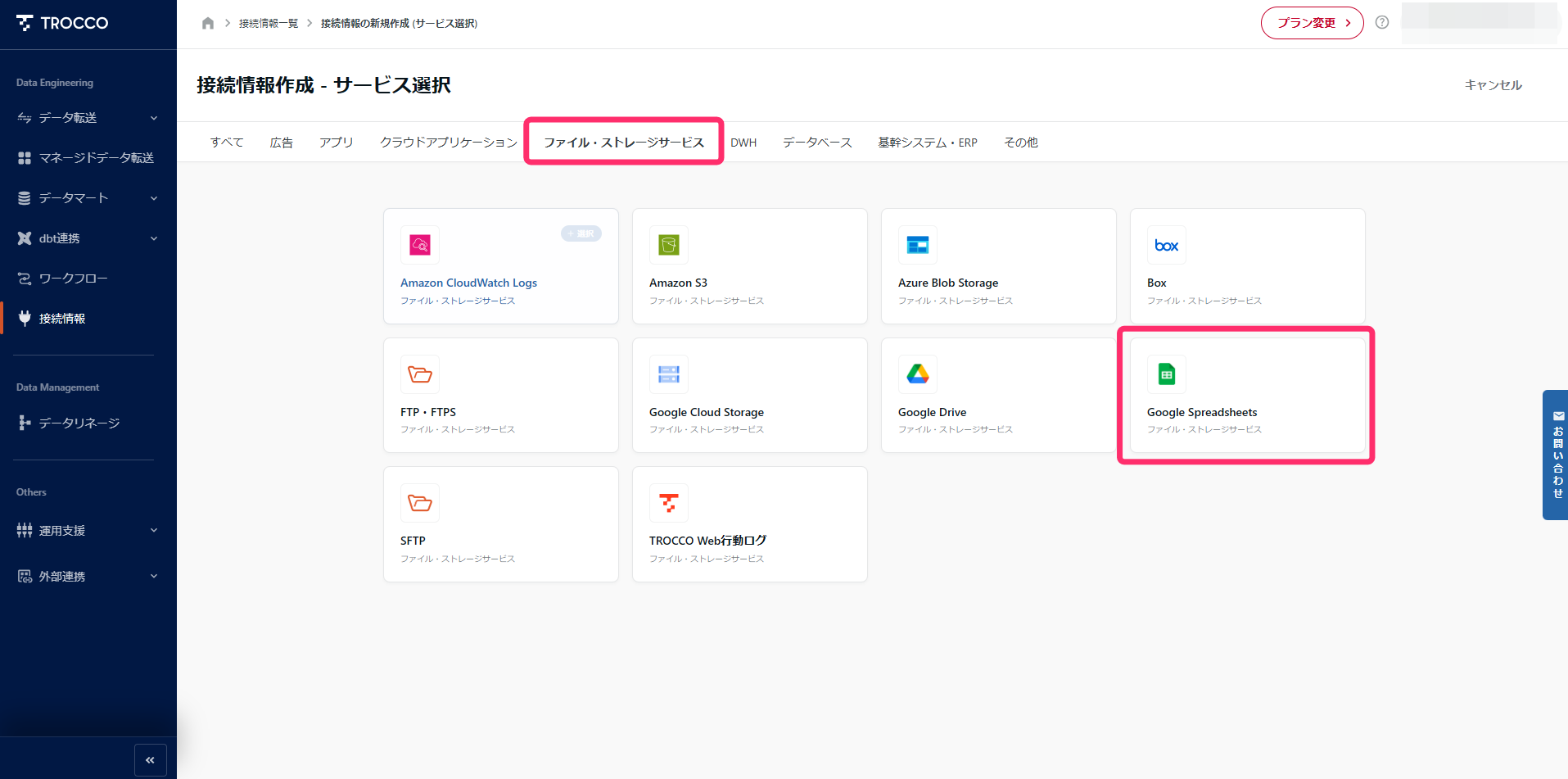

「ファイル・ストレージサービス」から「Google スプレッドシート」を選択します。

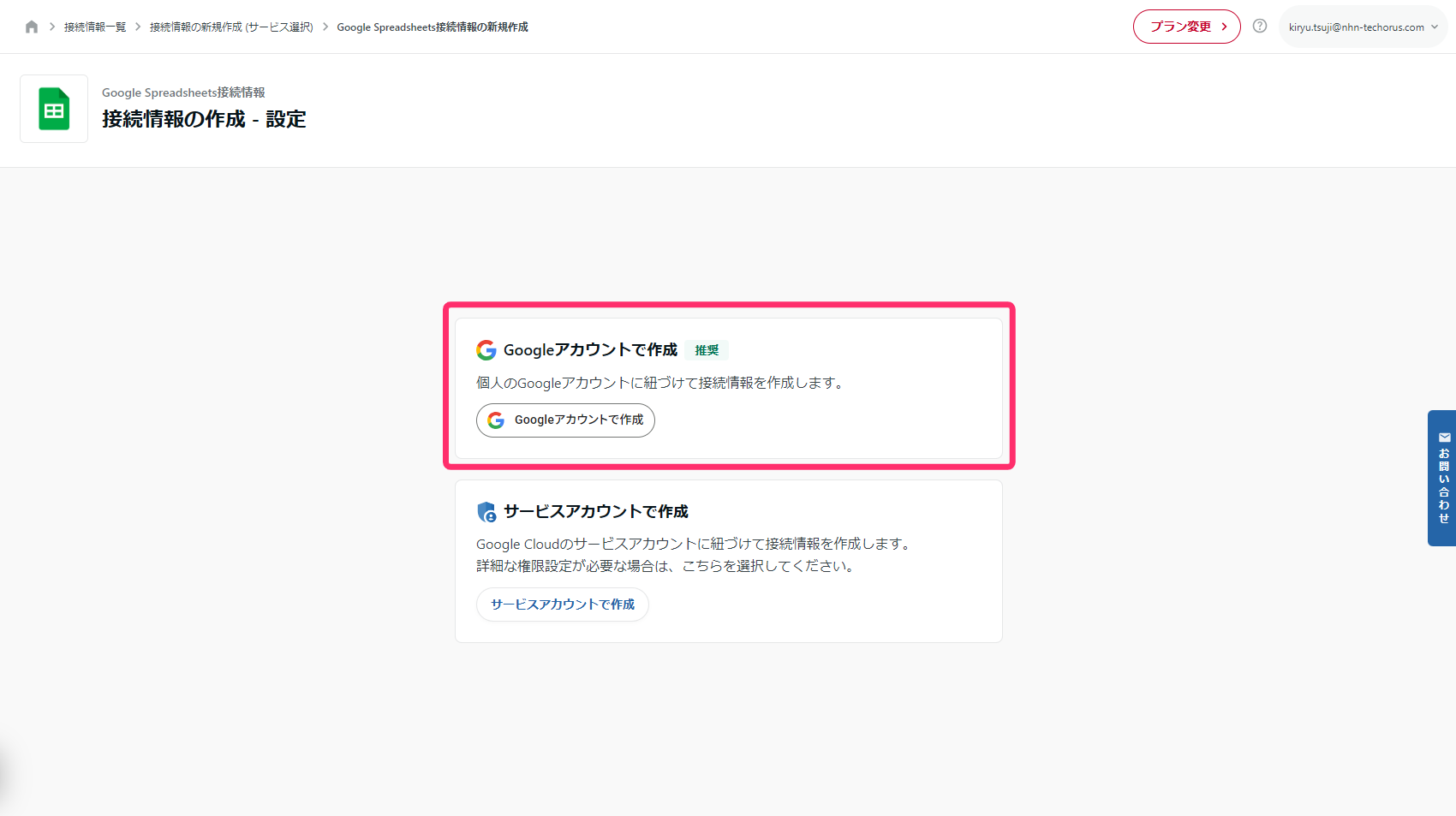

今回は、Google アカウントで認証を作成します。

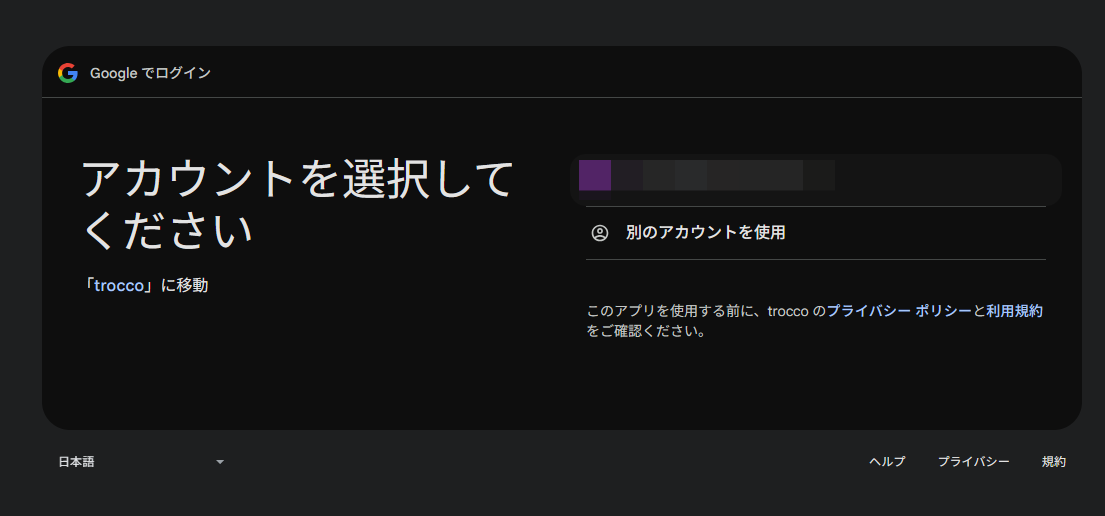

アカウントの認証を行います。

認証が完了すると設定完了です。

BigQuery 接続情報

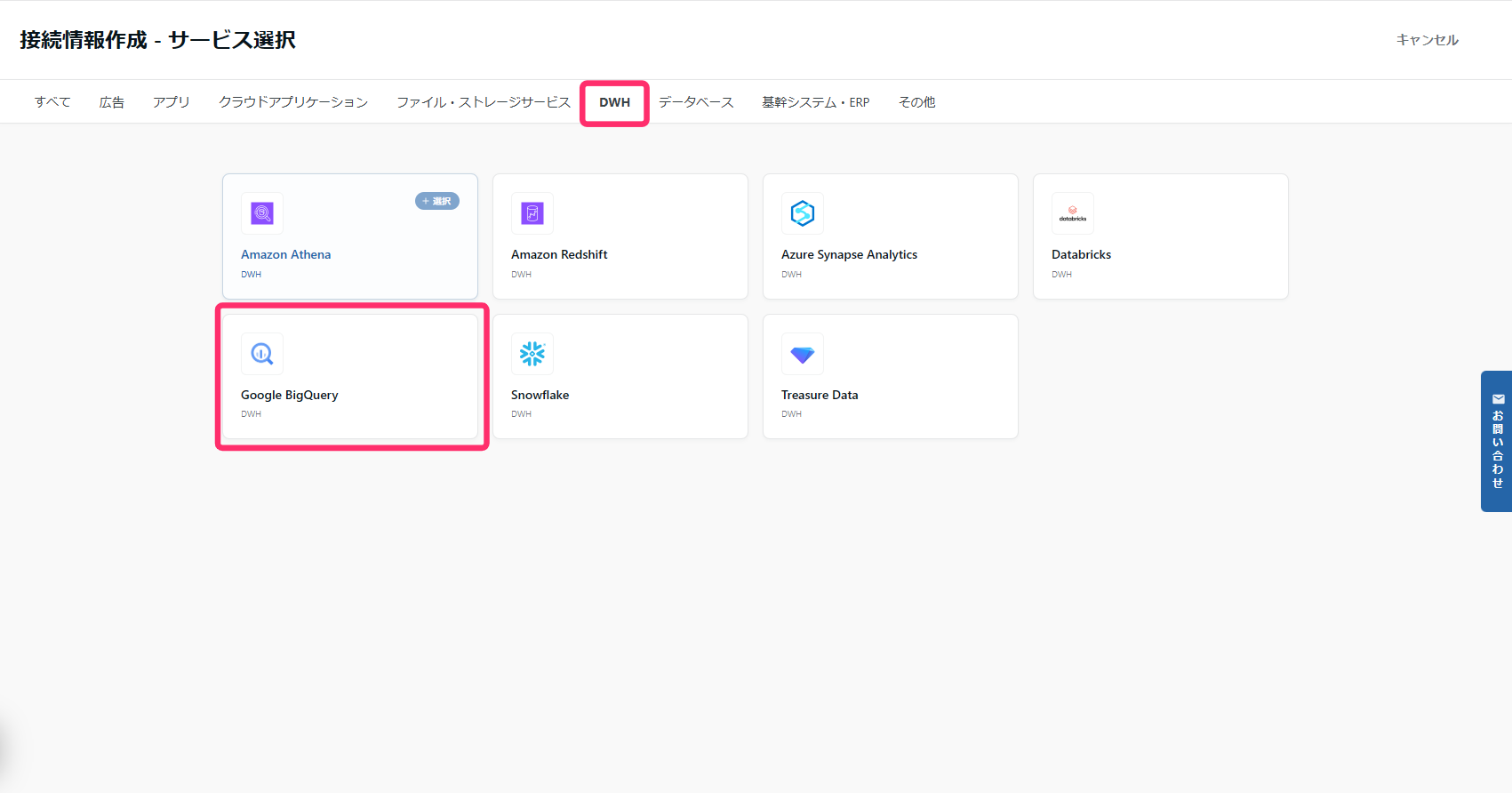

次に、BigQuery の接続情報を作成します。

「DWH」カテゴリーから BigQuery を選択します。

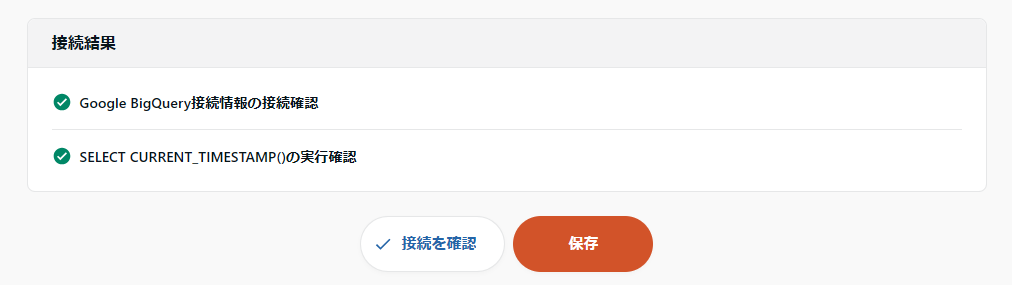

「サービスアカウント」を選択します。

先ほどダウンロードした JSON ファイルの内容を丸ごとコピーペーストし、プロジェクト ID も入力します。

接続テストを行い、問題がなければ設定完了です。

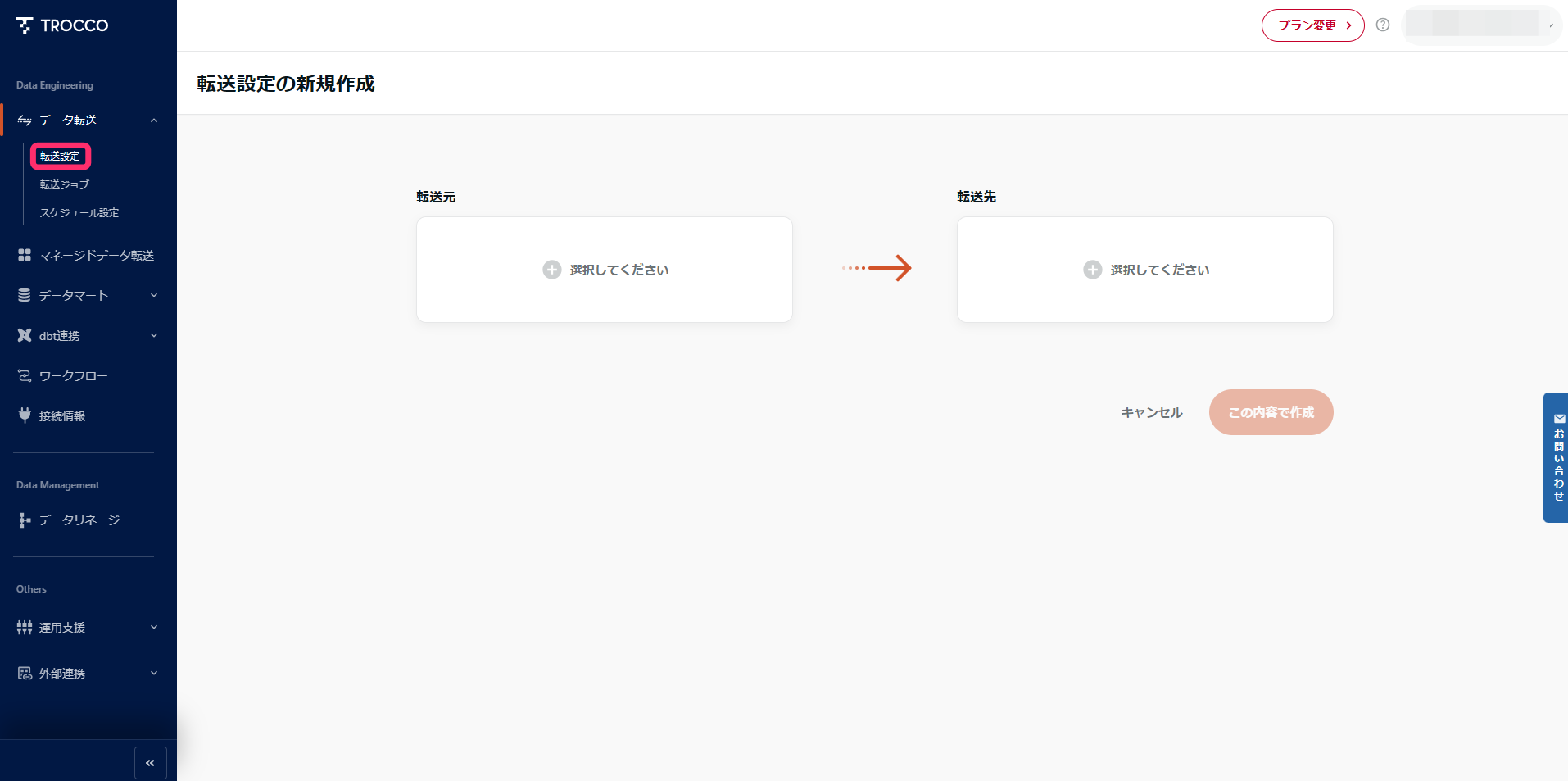

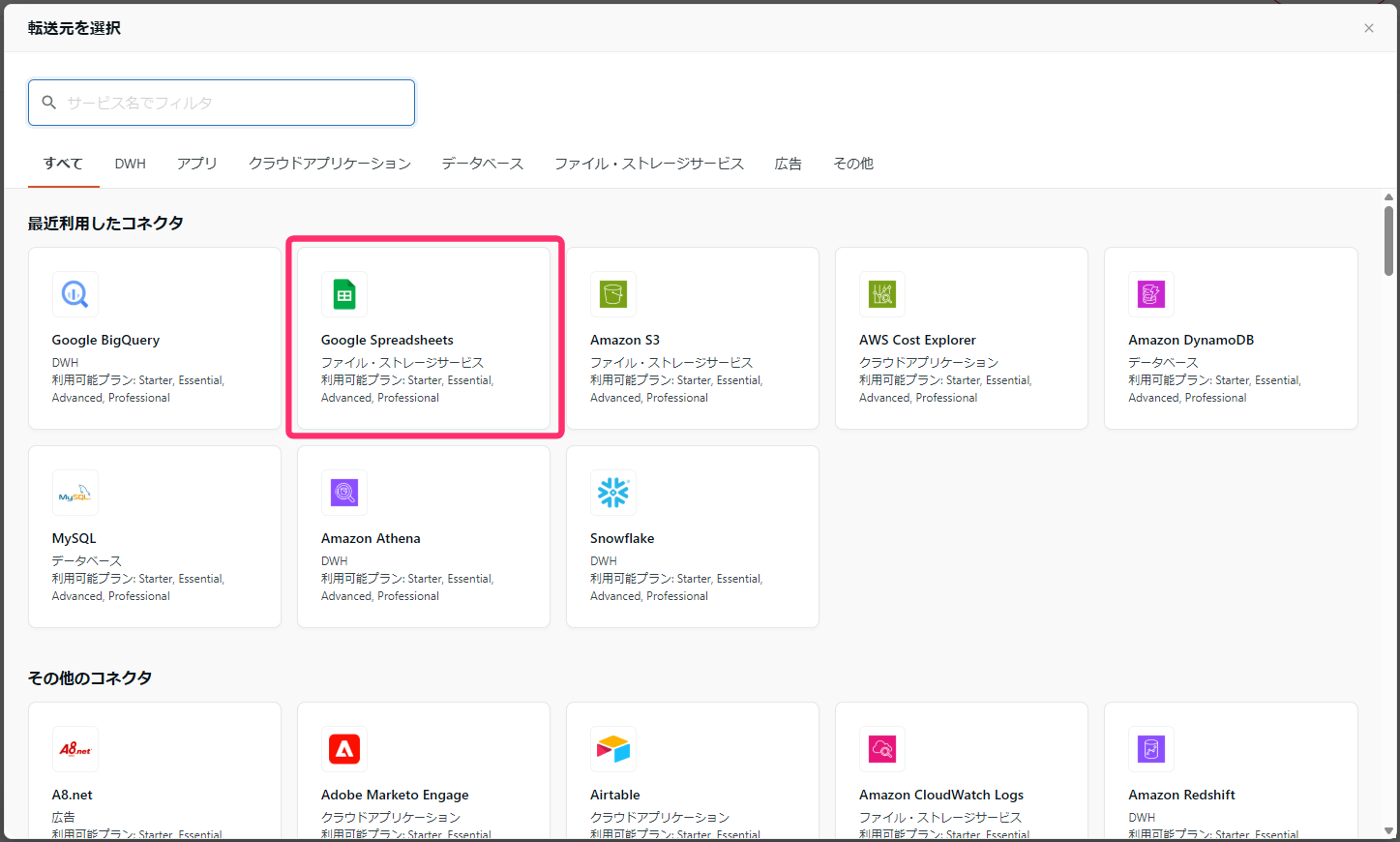

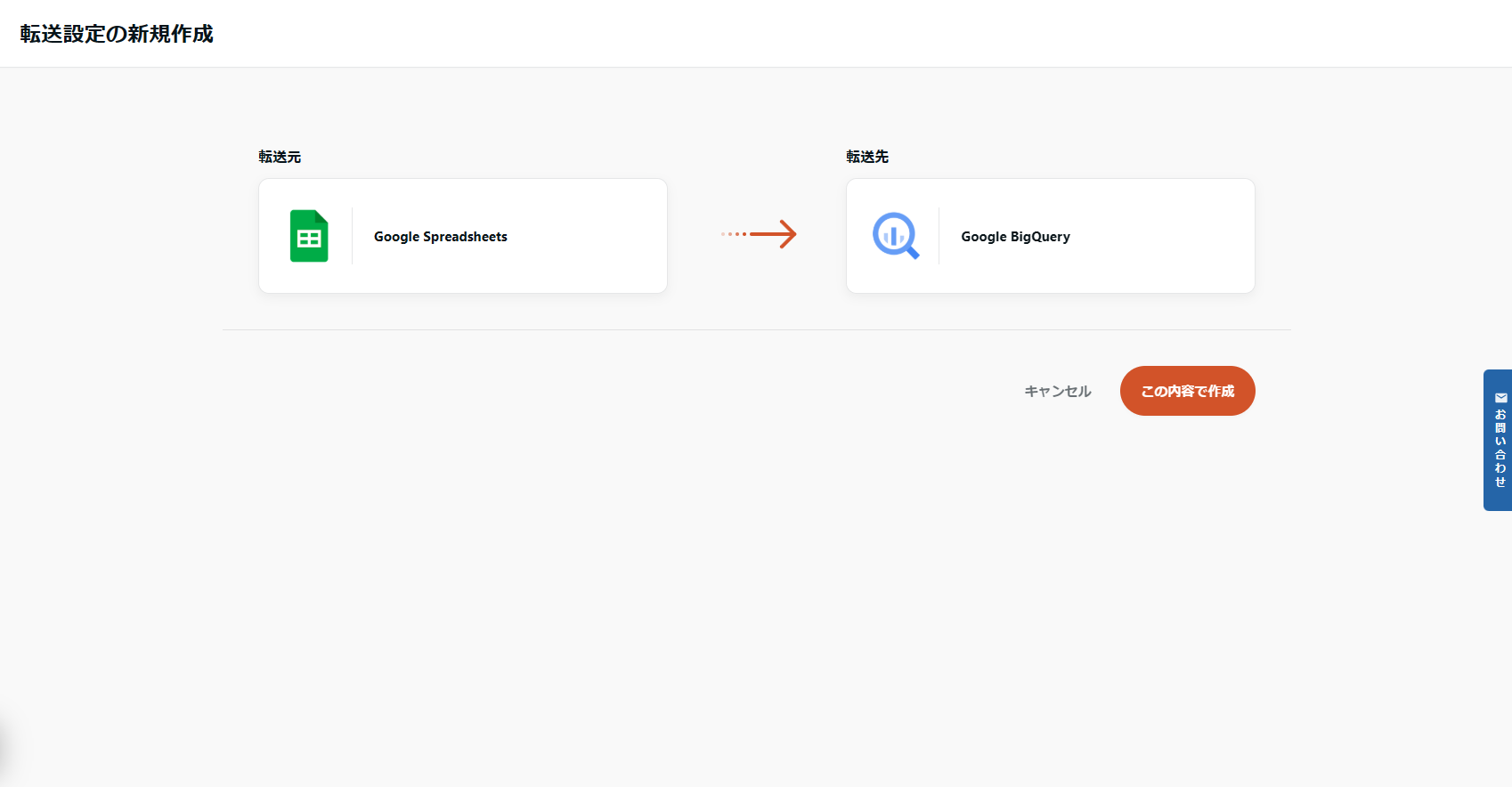

2. 転送設定の作成

実際にデータを転送する転送設定を作成します。

接続元と接続先を指定します。

- 接続元:Google スプレッドシート

- 接続先:BigQuery

選択が完了しました。

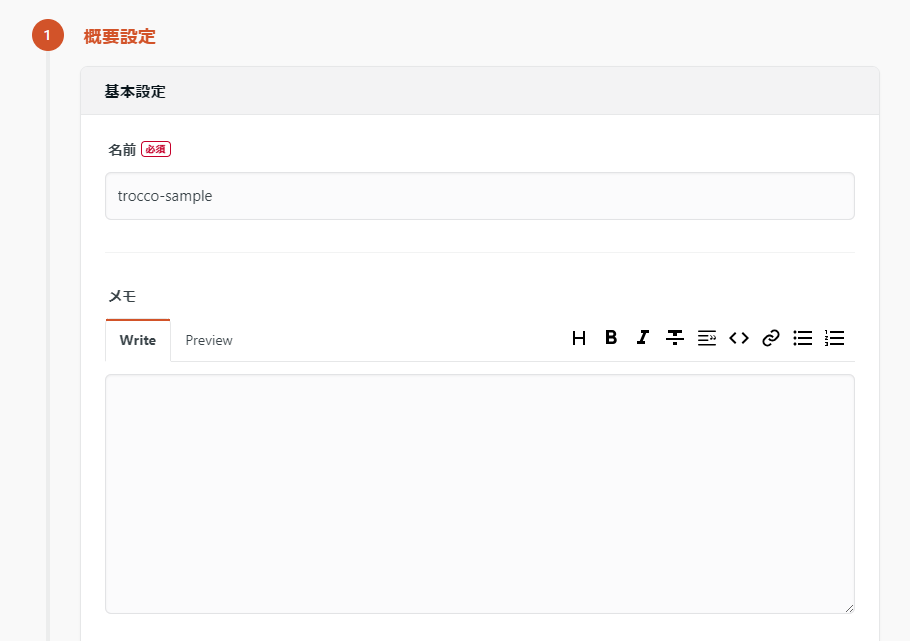

STEP1 : 転送元・転送先の設定

まずは、転送元(Google スプレッドシート)の設定から行います。

先ほど作成した接続情報を選択し、スプレッドシートの URL とシート名を入力します。

行と列の設定を行います。

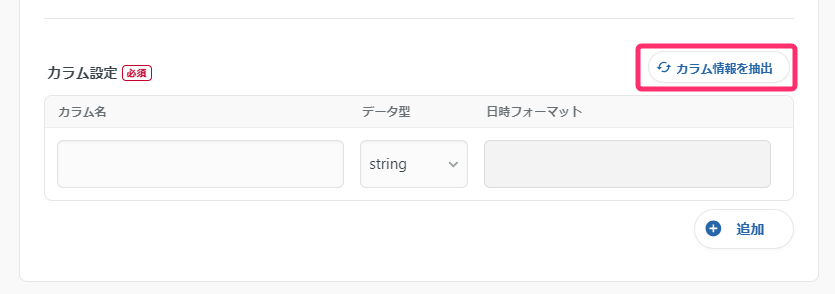

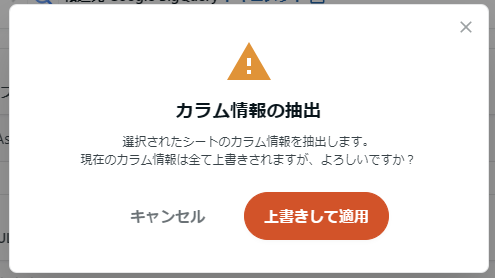

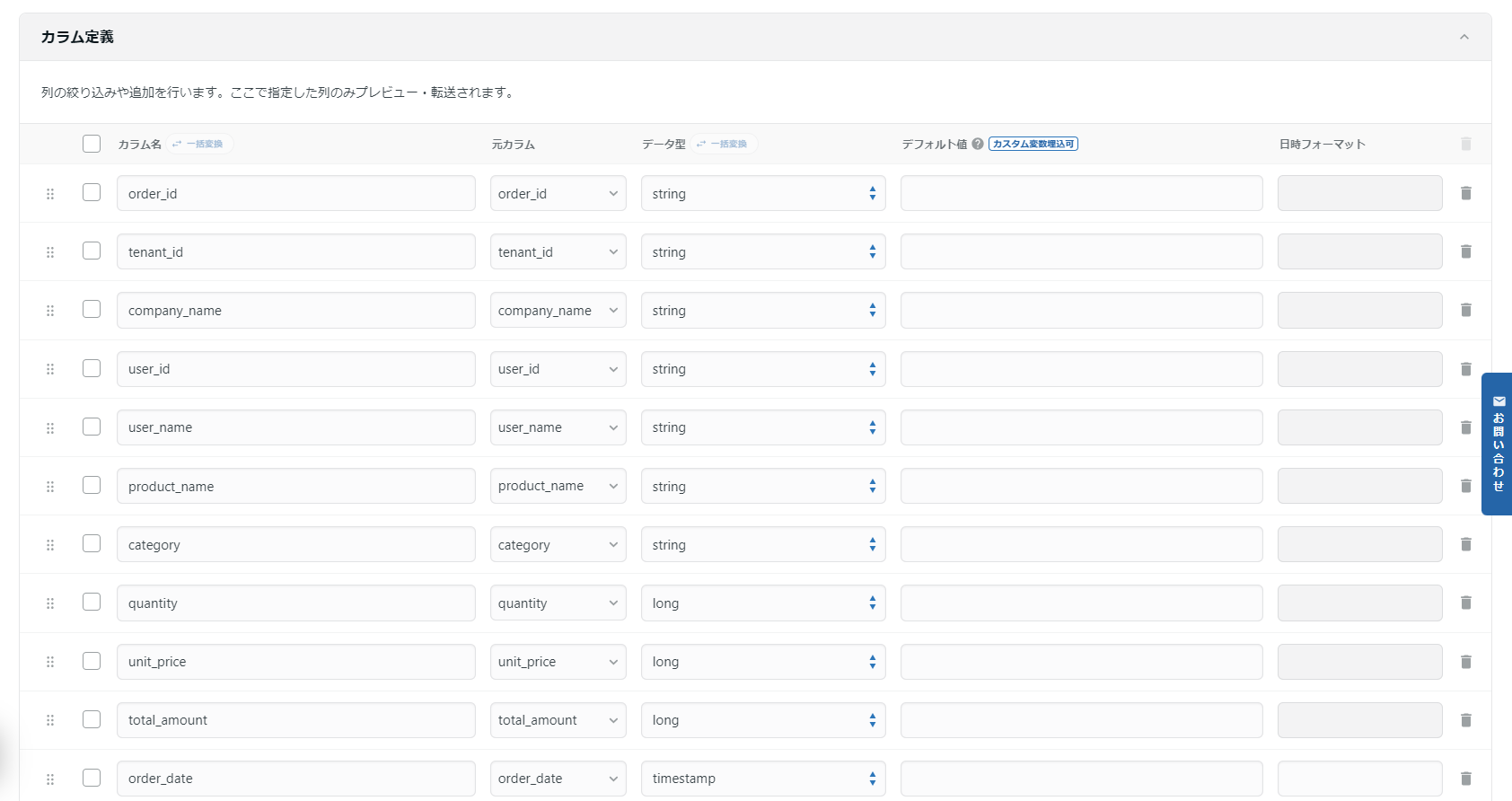

カラム設定では、「カラム情報の抽出」を選択して自動設定します。

警告が出ますが、問題ないので上書きして適用します。

すると、スプレッドシートの値をもとに自動的にカラムが設定されます。

転送先(BigQuery)の設定

BigQuery の接続情報を選択し、データセットとテーブル名を指定します。

今回、データセットは事前に作成していますが、テーブルは作成していないため、自動的に作成させます。

最後に接続確認をして問題なければ設定終了です。

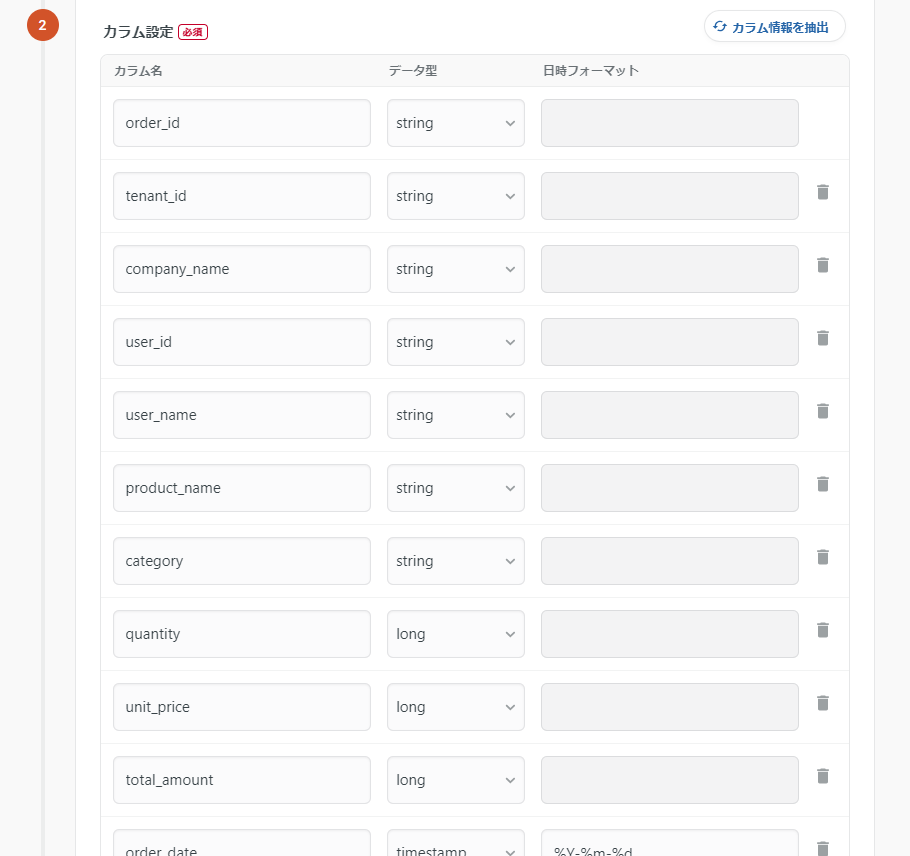

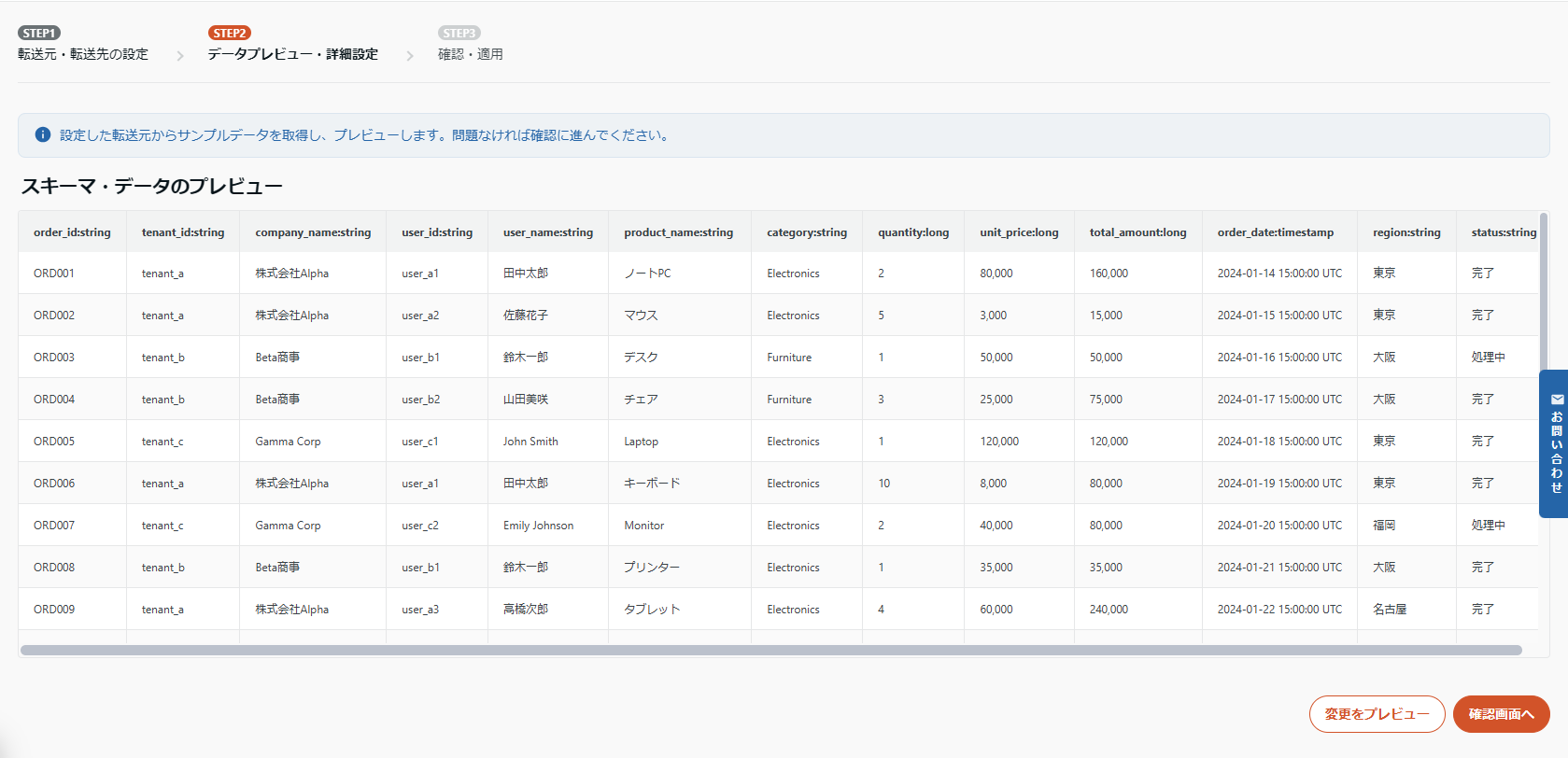

STEP2 : データプレビュー・詳細設定

「転送元・転送先の設定」が正しく行われていると、プレビューでデータが表示されます。

ここでは、必要に応じてカラム定義を修正できます。

今回は、変更操作は不要なため、特に何も行わず次に進みます。

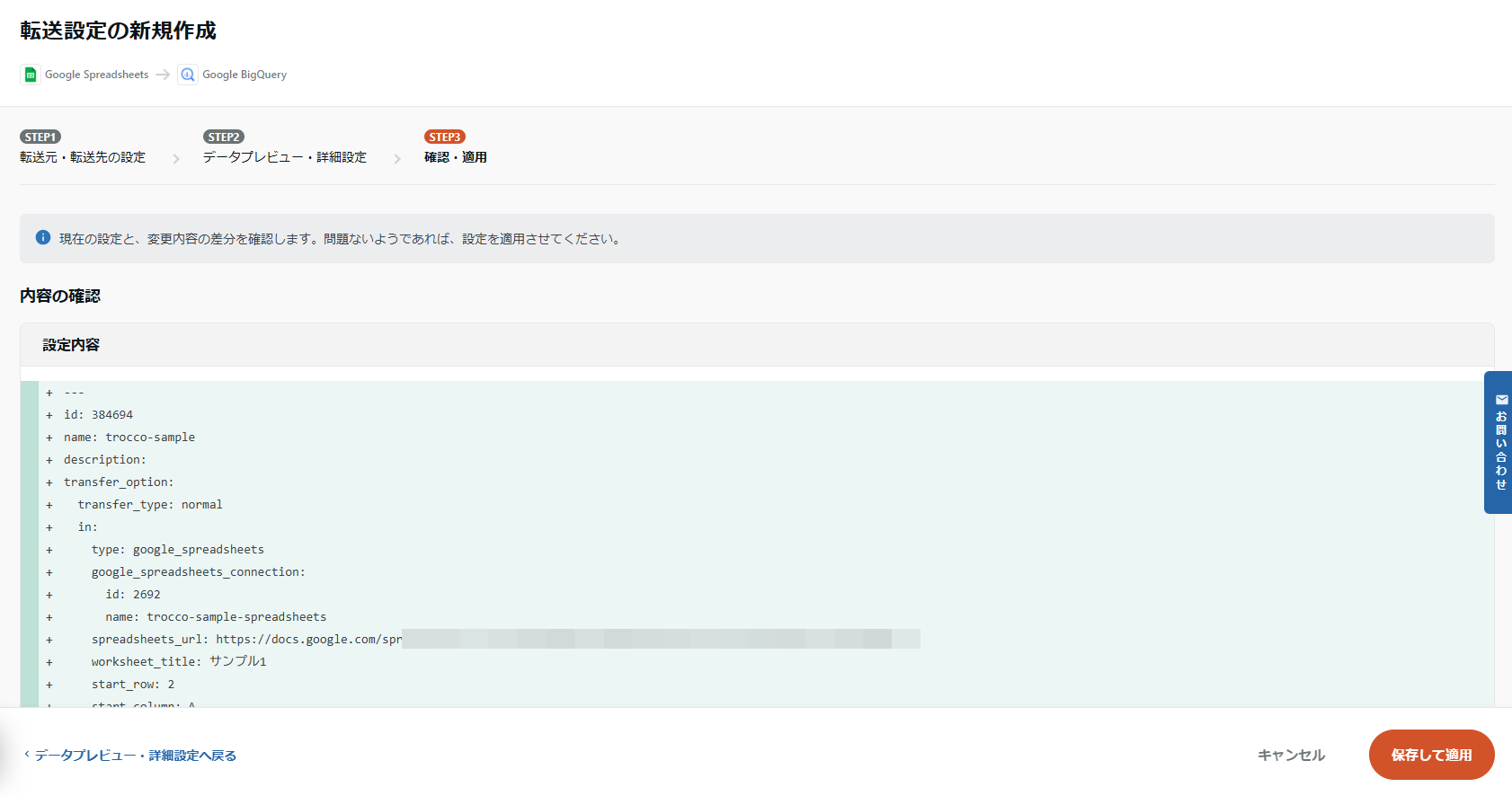

STEP3 : 確認・適用

最後に設定を確認して保存します。

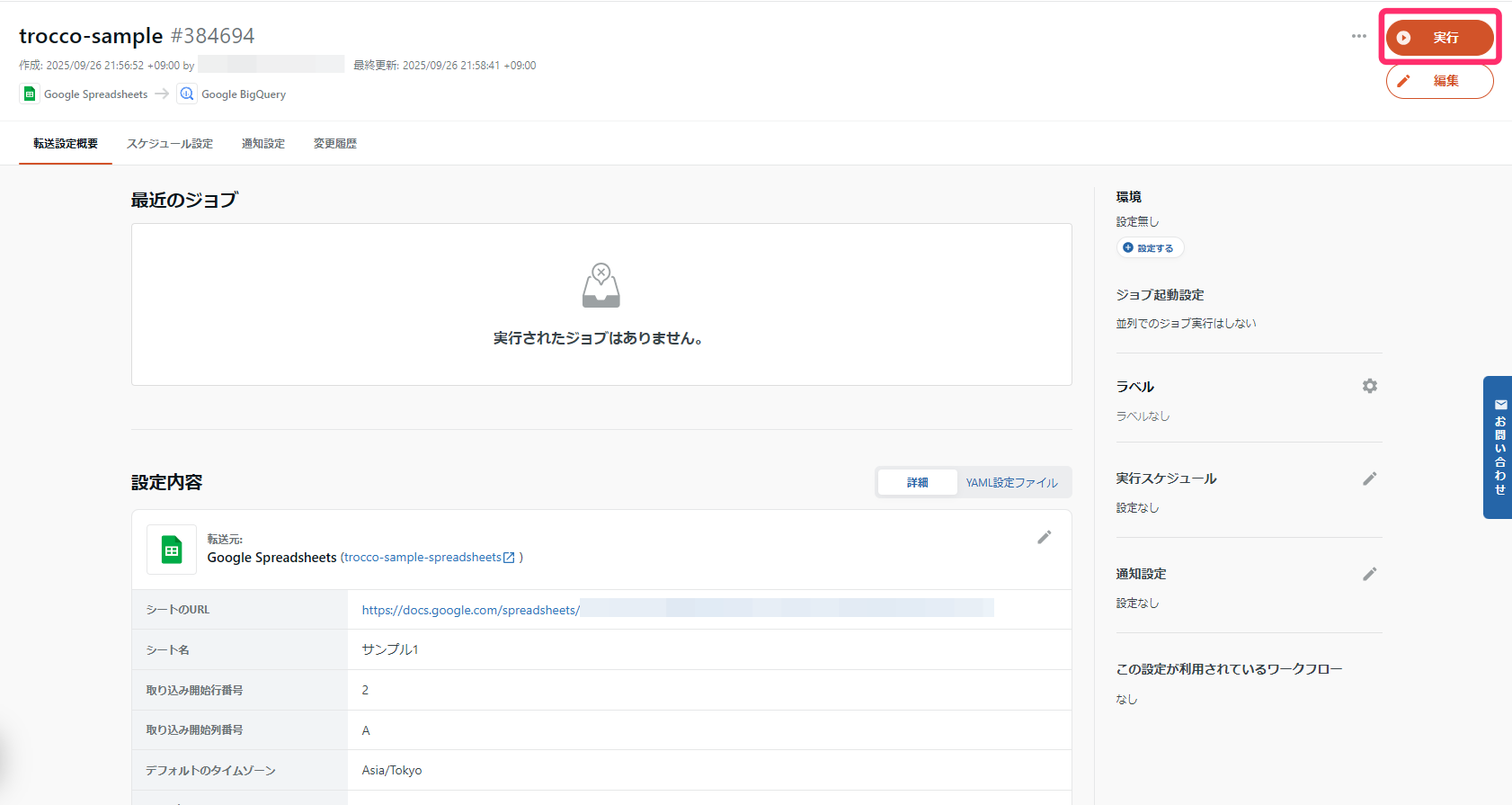

3. 転送ジョブの実行

先程作成した転送設定を選択して実行します。

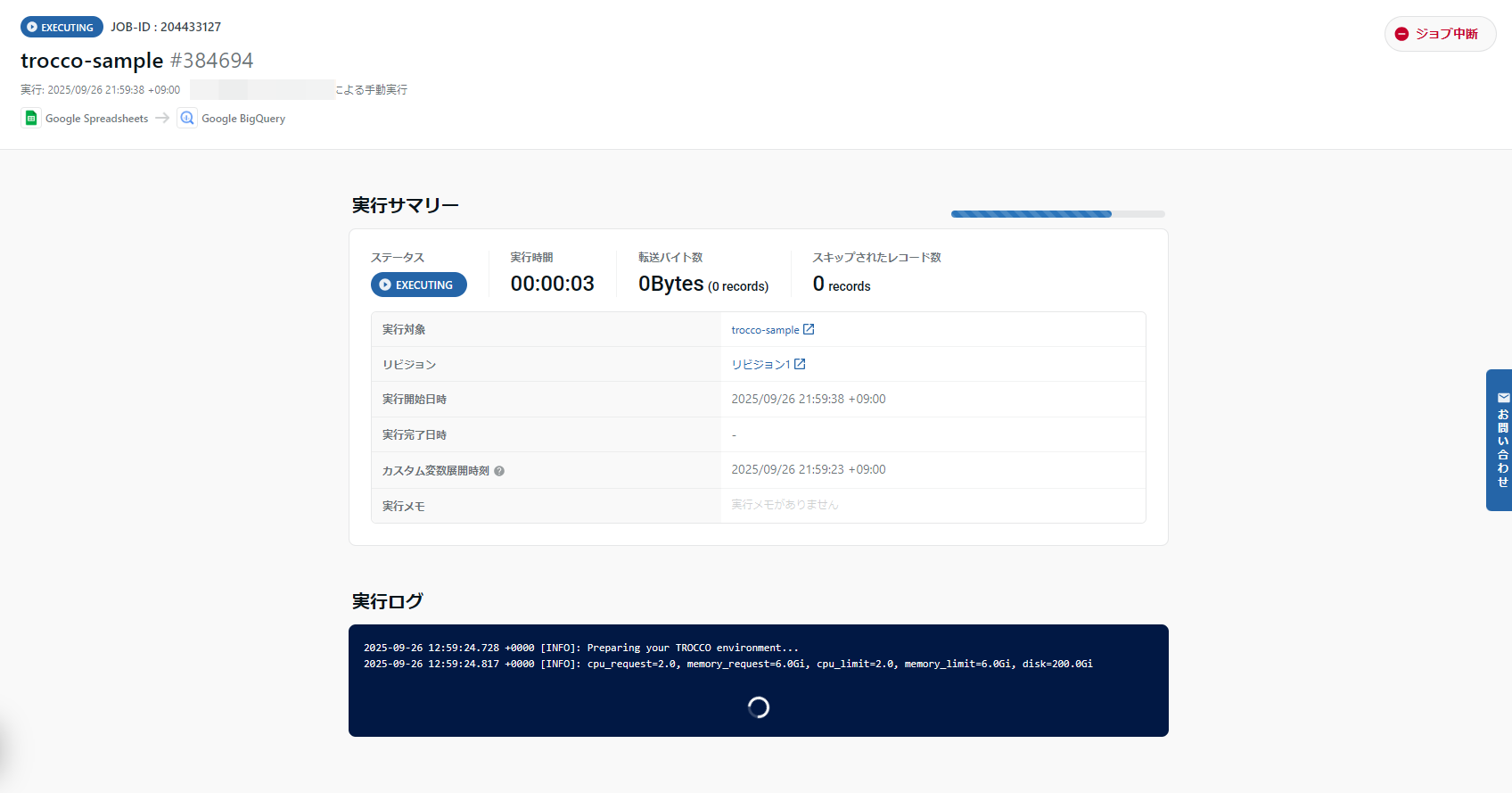

実行ボタンを押してジョブを開始します。

成功すると以下の画面が表示されます。

動作確認

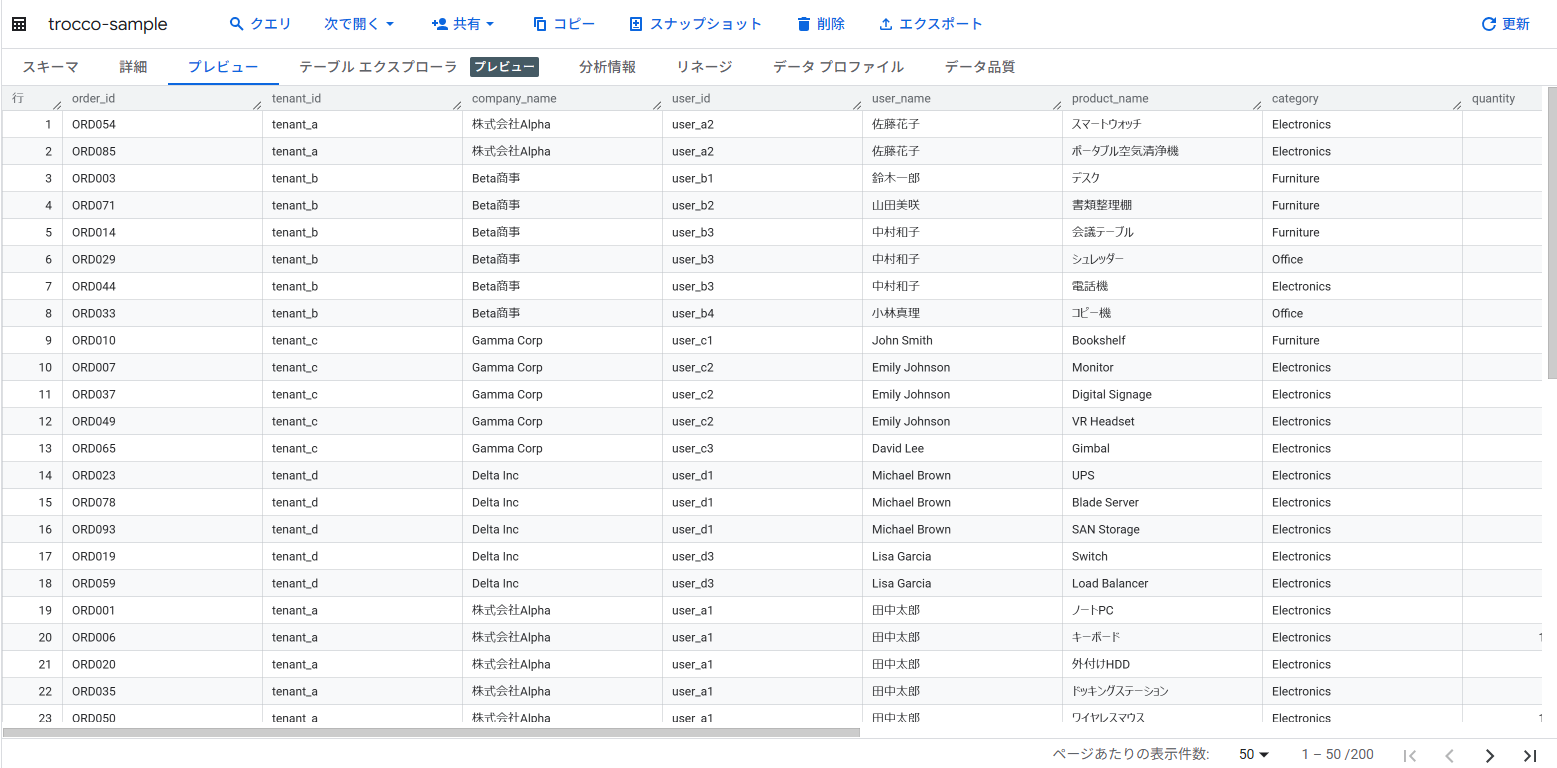

1. BigQuery でデータを確認

データが正常に転送されたか、BigQuery の画面で確認します。

正しくデータが転送されていることが確認できました。

まとめ

TROCCO を使用することで、以下のメリットが得られます。

- 簡単操作 : プログラミング不要で直感的な GUI 操作

- 無料で開始 : Free プランで気軽に試せる

- 日本語対応 : コンソールから操作まで完全日本語対応

- 豊富な連携先 : 100 種類以上のコネクタで様々なサービスと連携可能

データ分析の第一歩として、ETL 作業を自動化することで、より価値の高い分析業務に集中できるようになります。

NHN テコラスの採用情報はこちら

2021年新卒入社。インフラエンジニアです。RDBが三度の飯より好きです。 主にデータベースやAWSのサーバレスについて書く予定です。あと寒いのは苦手です。

Recommends

こちらもおすすめ

-

【初心者向け】BigQueryって聞いたことあるけど、どんなサービス?

2023.12.22

-

Google BigQueryからAmazon Redshiftにデータを移行してみる

2019.11.29

-

TROCCO を Terraform で構築してみた

2025.11.4

Special Topics

注目記事はこちら

データ分析入門

これから始めるBigQuery基礎知識

2024.02.28

AWSの料金が 10 %割引になる!

『AWSの請求代行リセールサービス』

2024.07.16