AICによるARモデルのモデル選択

こんにちは。データサイエンスチームのtmtkです。

この記事では、AICによるARモデルのモデル選択について説明します。

背景

前回の記事では、時系列解析の入門としてARモデルを紹介しました。そこでは、パラメータのうち次数の推定という課題が残っていました。

次数は増やせば増やすほど、既存のデータに対する適合性はあがりますが、増やしすぎると未知のデータに対する予測性能が悪くなることが知られています。この現象は過学習や過適合とよばれます。

AIC(An Information CriterionまたはAkaike Information Criterion、赤池情報量規準)というのはARモデルの“ちょうどいい”次数を見つけるのに使える指標です。

AICとは

AICについての詳細は各種書籍にゆずることにし、ここでは簡単に定義と結論だけ述べます。

AICは

ARモデルのAIC

それでは、実際にARモデルのAICを計算し、最適なモデル選択をしてみます。

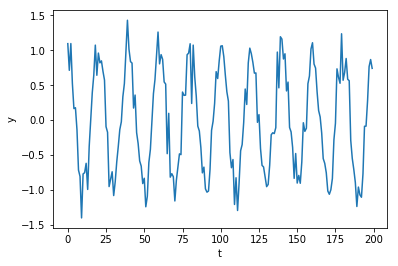

データとして、コサインカーブに正規分布ノイズを加えたデータを使います。

import numpy as np np.random.seed(1234) N = 200 std = 0.2 x = np.arange(0, N) y = np.cos(x*np.pi/10) + np.random.normal(0, std, N)

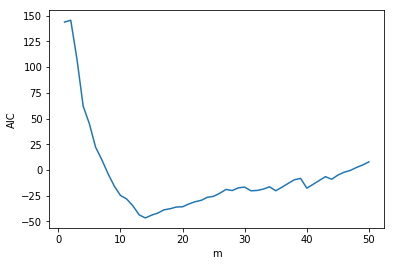

200個のサンプルのうち、最後の20個のサンプルはテスト用データセットとしてホールドアウトしておき、残りの180個のデータに対し、ARモデルを作成します。次数

を1から50まで変化させたとき、AICは以下のように変化します。

次数のモデルがAIC最小を達成するモデルだとわかります。次数が

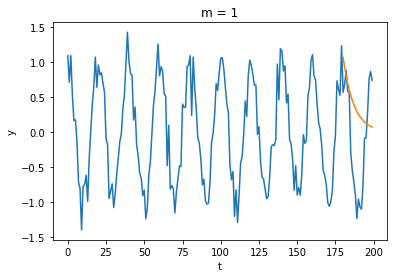

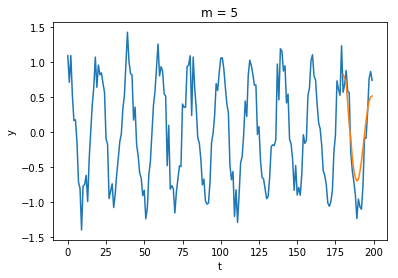

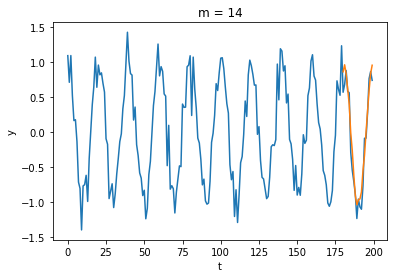

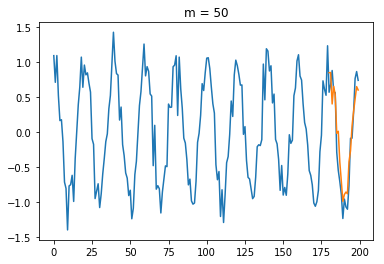

それぞれの場合に対して、

とARモデルから

を推定したものをプロットしてみます。

の場合とくらべると、明らかに

の場合はよいモデルになっていることがわかります。

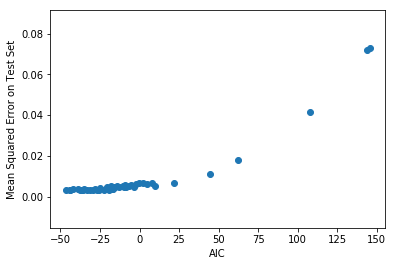

AICとホールドアウト法

以上で、AICによるARモデルの選択を説明しました。機械学習の文脈では、モデル選択の方法として、ホールドアウト法やそれを発展させた交差検証法(Cross Validation)がよく使われていると思います。そこで、AICによるモデル選択と、ホールドアウト法によるモデル選択の関係を実験的に調べてみます。

上の実験と同様の状況で、各次数に対するAICと平均二乗誤差(Mean Squared Error)の関係を調べます。平均二乗誤差は、

からARモデルで予測した

と、実際の

を比べて計算します。

AICと平均二乗誤差をプロットすると、以下のようになります。

AICが小さくなるほど平均二乗誤差も小さくなる傾向を読み取ることができます。したがって、この場合はAIC最小のモデルを選ぶことと、ホールドアウトしたデータセットに対する平均二乗誤差が最小になるモデルを選ぶことは、おおむね同じことになります。

まとめ

この記事では、AICを説明し、AICを使ってARモデルの次数選択を行いました。

また、AICが小さいモデルほど、予測誤差が小さくなる傾向を、実験的に確認しました。

参考文献

- 北川源四郎『時系列解析入門』

- 坂元慶行・石黒真木夫・北川源四郎『情報量統計学』

- 信号解析 第8回講義録

テックブログ新着情報のほか、AWSやGoogle Cloudに関するお役立ち情報を配信中!

Follow @twitterデータ分析と機械学習とソフトウェア開発をしています。 アルゴリズムとデータ構造が好きです。

Recommends

こちらもおすすめ

-

ARモデルの誤差分析について

2019.3.7

-

基礎からはじめる時系列解析入門

2019.2.22

-

ARモデルの表現能力を考察する

2019.3.1

-

社内マッサージルーム利用状況がパレートの法則にしたがっているかを検証する

2018.9.26

-

機械学習の受託案件を通じて気づいた5つのこと

2019.3.8

Special Topics

注目記事はこちら

データ分析入門

これから始めるBigQuery基礎知識

2024.02.28

AWSの料金が 10 %割引になる!

『AWSの請求代行リセールサービス』

2024.07.16